HDFS大規模數據存儲底層原理詳解 數據處理和存儲支持服務

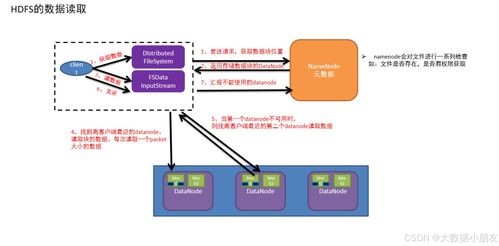

在深入了解Hadoop分布式文件系統(HDFS)的第31天,我們聚焦于其數據處理和存儲支持服務。這些服務是HDFS實現高吞吐量、高可靠性、可擴展性數據存儲的核心機制,它們共同確保了系統在面對海量數據時的穩定與高效。

一、 核心數據處理與存儲服務概述

HDFS并非一個簡單的文件存儲系統,它提供了一系列底層服務來支持上層的數據處理框架(如MapReduce、Spark等)。這些服務主要圍繞數據塊的存儲、復制、恢復和管理展開,確保數據的安全性、可用性和訪問效率。

二、 數據塊的存儲與復制服務

這是HDFS最基礎也是最重要的支持服務。

- 分塊存儲:HDFS將大文件自動切分為固定大小的數據塊(Block,默認為128MB或256MB)。這種設計簡化了存儲管理,并使并行處理成為可能,因為每個塊可以獨立地在不同的DataNode上進行處理。

- 多副本復制:每個數據塊會被復制到多個(默認為3個)不同的DataNode上。這一服務由NameNode協調,由DataNode執行。它提供了:

- 數據可靠性:單點或少數節點故障不會導致數據丟失。

- 讀取負載均衡:客戶端可以從多個副本中選擇一個進行讀取,提升讀取帶寬。

- 數據本地性計算:計算任務可以被調度到存有數據副本的節點上執行,減少網絡傳輸開銷。

三、 數據持久化與一致性服務

- FsImage與EditLog:NameNode使用兩個關鍵文件來維護整個文件系統的元數據(命名空間)。

- FsImage:是文件系統元數據的一個持久化檢查點,記錄了文件到數據塊的映射、文件屬性等信息。

* EditLog:記錄自最新FsImage之后的所有文件系統更改操作(如創建、刪除文件)。

這種“檢查點+日志”的機制確保了元數據的一致性和快速恢復能力。Secondary NameNode(或在高版本中的Checkpoint Node/Standby NameNode)會定期協助合并FsImage和EditLog,防止EditLog無限增長。

- 數據管道寫入:當客戶端寫入數據時,HDFS會建立一個數據管道。數據塊被分成更小的數據包(packet),依次流經管道上的各個副本DataNode。這種流水線操作不僅提高了寫入效率,也確保了副本間的一致性。

四、 容錯與恢復服務

- 心跳與塊報告:DataNode定期向NameNode發送心跳信號,以表明其存活狀態。DataNode還會發送塊報告,告知NameNode其上存儲的所有數據塊列表。NameNode據此構建并維護整個集群的數據塊映射表。

- 副本重新復制:當NameNode通過心跳機制檢測到某個DataNode宕機,或通過塊報告發現某個數據塊的副本數量因故障低于設定閾值時,它會觸發副本重新復制服務,將該數據塊從其他存活的副本復制到新的DataNode上,以恢復其副本因子。

- 租約管理:對于正在寫入的文件,NameNode會授予客戶端一個租約(Lease),以防止其他客戶端并發寫入造成沖突。此服務確保了寫入操作的一致性。

五、 存儲空間管理服務

- 存儲負載均衡:HDFS會嘗試將數據塊及其副本均勻地分布在集群的所有DataNode上。這既包括初始放置時的策略(考慮機架感知),也包括后臺運行的Balancer工具,它可以在集群運行過程中,在DataNode之間遷移數據塊,以平衡磁盤空間利用率和網絡流量。

- 垃圾回收:當文件被刪除或修改時,其對應的數據塊并不會立即從物理磁盤上清除。HDFS提供了一個垃圾回收機制(配置有回收站功能),數據塊會被移動到“垃圾桶”目錄,在超過保留時間后才被永久刪除,這為用戶提供了誤刪恢復的機會。

六、 支持上層計算框架的服務

- 數據本地性優化:HDFS向YARN等資源調度器暴露數據塊的位置信息。這使得調度器能夠優先將計算任務分配給存儲有該任務所需數據的DataNode(同節點),或至少是同機架的節點,從而最大程度地減少數據傳輸的網絡開銷,這是實現“移動計算而非移動數據”理念的關鍵。

- 集中式的元數據管理:NameNode作為單一的元數據管理者,為上層的所有計算作業提供了一個統一的、全局的文件系統視圖。這使得大規模并行計算作業可以高效、一致地訪問海量數據。

HDFS的數據處理和存儲支持服務是一個精心設計的生態系統。它通過分塊、多副本保障了數據的基礎可靠性與并行性;通過心跳、租約、檢查點等機制實現了系統的自動化容錯與一致性維護;并通過負載均衡、位置感知等服務,無縫地支撐了上層分布式計算框架的高效運行。理解這些底層服務,是掌握大數據存儲與處理技術棧的堅實基礎。

如若轉載,請注明出處:http://www.ya1987.cn/product/33.html

更新時間:2026-01-22 23:36:50